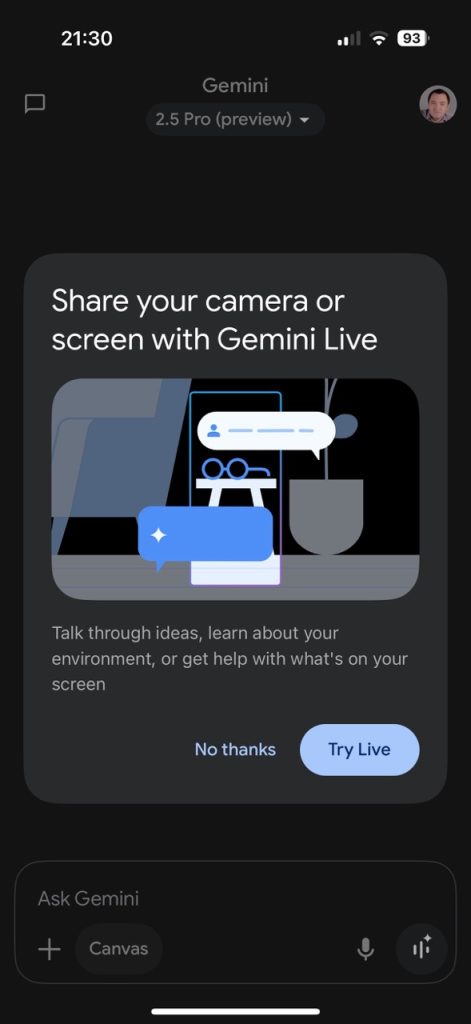

După update-ul Gemini de ieri am văzut că opțiunea de folosire a camerei, anunțată de Google săptămâna trecută la Google I/O, e activă. Asta înseamnă că cei ce sunt dispuși să lase aplicația Gemini să folosească camera foto, au acum posibilitatea de a folosi AI-ul Gemini Live ca să … ‘vadă’ lucruri în locul lor.

Așa că nu doar veți putea vorbi cu AI-ul Gemini în limba română, dar dacă îl lăsați de accese și camera, puteți să îl întrebați direct chestii despre ce se întâmplă în jurul … ca să nu mai trebuiască să gândiți prea mult.

Google împachetează funcția asta într-un mod frumos: să zicem că vreți să reparați ceva la o bicicletă și nu știți să desfaceți frâna, sau lanțul. Activați Gemini Live, porniți camera și îi cereți ajutorul – în teorie o să înțeleagă despre ce e vorba și o să vă propună soluții. Am făcut asta aseară și bineînțeles că Gemini Live a dat rateuri (după cum spun unii, e abia la început și mai are de învățat): câte lămpi vezi pe masă? Răspuns … 3 :).

Ca sunt corecte sau nu … vedeți voi. De preferat înainte să le puneți în practică, ca să nu vă pară rău ulterior.

Gemini Live cu camera deschisă e urmașul Google Lens, idee care a pornit cu ceva ani în urmă, atunci când Google ne spunea că putem să aflăm lucruri interesante despre locurile în care ne aflăm (pentru turiști mai mult) prin orientarea camerei către anumite clădiri/construcții (era luată poza, locația și se încerca identificarea clădirii/construcției cu cele din Google Street).

Între timp povestea a trecut la nivelul următor: Google își dorește foarte tare să ne tâmpească, atacacându-ne din toate direcțiile cu AI.

Mie nu mi se pare că ar aduce vreun beneficiu, din contră: contribuie la reducerea capacităților cognitive, a simțului de orientare, de descriere etc. Și de asta nu am de ce să folosesc, pentru că în acest moment nu are să îmi ofere niciun plus.

Voi … faceți ce vreți. Eu v-am zis că există.