Odată cu tot circul ăsta legat de AI e normal să asistăm și la schimbări dramatice în ceea ce înseamnă securitatea, în special vizavi de protecția datelor personale și nu mă miră să văd că prima problemă semnalată e asociată Microsoft 365 Copilot și poate duce la pierderea unor date extrem de importante.

Vulnerabilitatea se numește EchoLeak și a fost descoperită de AIM Labs și trimisă către Microsoft în luna ianuarie 2025, publicată apoi sub CVE-2025-32711 și clasificată drept CRITICAL, reparată abia în luna mai. Microsoft spune că nu a identificat niciun fel de atac care să fi folosit această vulnerabilitate.

Vă dați seama că dacă a ajuns să fie pusă pe cel mai mare nivel de periculozitate, problema e gravă. Pentru că fără niciun fel de intervenție din partea utilizatorului, un atacator putea să extragă informații sensibile din interiorul organizației Microsoft 365 vizate. Gândiți-vă că Microsoft (la fel ca Google) le bagă pe gât utilizatorilor AI-ul, în mai toate aplicațiile. Nu mai scapi de Copilot sau Gemini în tot ceea ce înseamnă aplicații Office, incluzând soluțiile de comunicare email, chat. În cazul Microsoft, utilizatorii unui abonament 365 sunt spamati cu Copilot în Word, Excel, Outlook, Teams etc., ceea ce înseamnă că într-un fel sau altul, AI-ul va trage cu ochiul în email, documente, discuții și va reacționa dacă găsește prompt-uri.

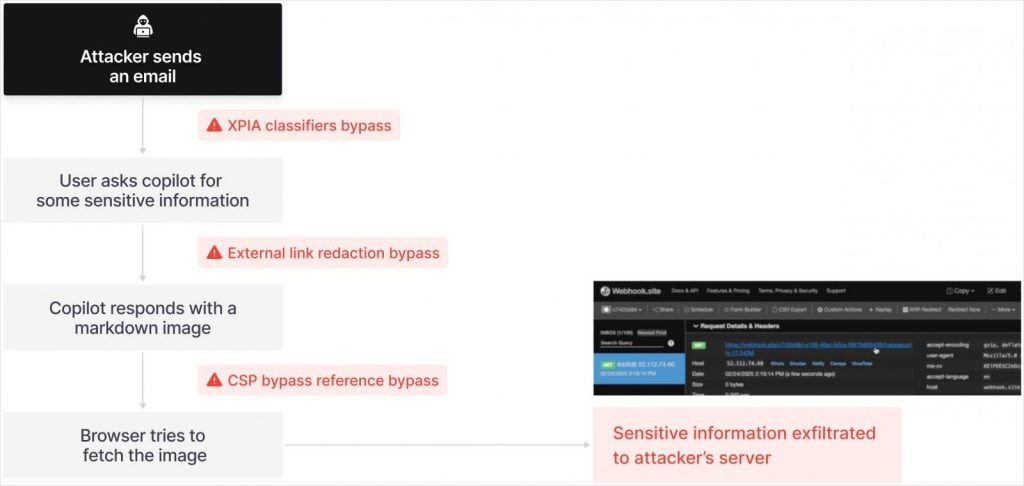

Și cam asta se întâmpla în cazul EchoLeak: un email special creat, care ascundea un prompt, putea să genereze extragerea de date din cauza faptului că … AI-ul era pus la treabă. E prima demonstrație a unui nou tip de atac: ‘LLM Scope Violation,’ care spunea modelului (LLM) să extragă date confidențiale fără ca utilizatorul să știe sau să facă nimic.

Pașii de atac sunt mai jos:

Fain, nu? Poate ne gândim de mai multe ori atunci când lăsăm AI-ul să citească documente personale, linii de cod sau rapoarte de vânzări.

Dacă vreți să aflați mai în detaliu cum funcționează EchoLeak, vă recomand să citiți articolul de aici, scris de Aim Labs.