Dacă vreți să testați local un AI, pe care să îl configurați și să funcționeze așa cum vă doriți, fără a vă divulga datele, atunci poate ar fi bine să aruncați o privire peste Google AI Edge Gallery. Este o aplicație nouă, ce încă nu e publicată în Play Store (deci trebuie instalată dintr-un APK) care vă permite să rulați local un LLM direct pe telefonul Android (pentru moment).

După ce m-am jucat cu AnythingLLM pe Asus Vivobook S15 folosind NPU-ul mi s-a părut interesant să văd cum poate funcționa și pe smartphone, mai ales că de câțiva ani am tot dat bani pe telefoane noi, capabile de AI via NPU.

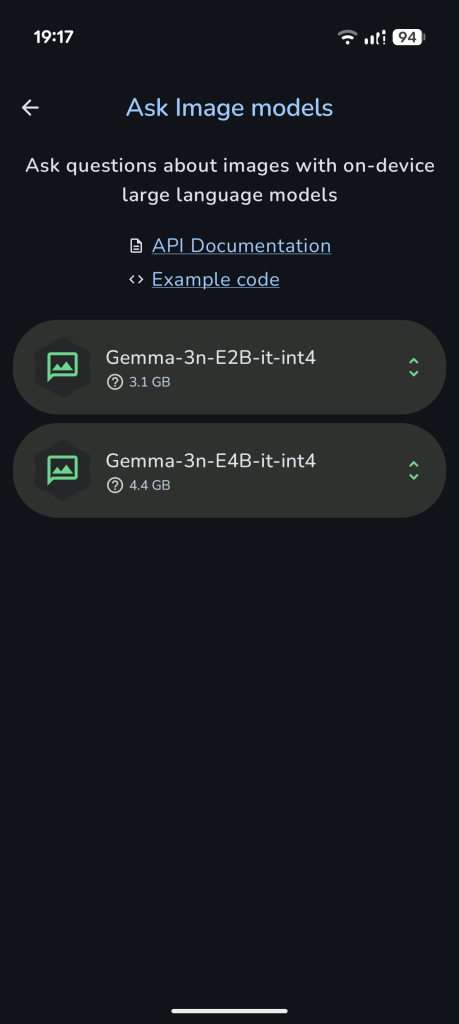

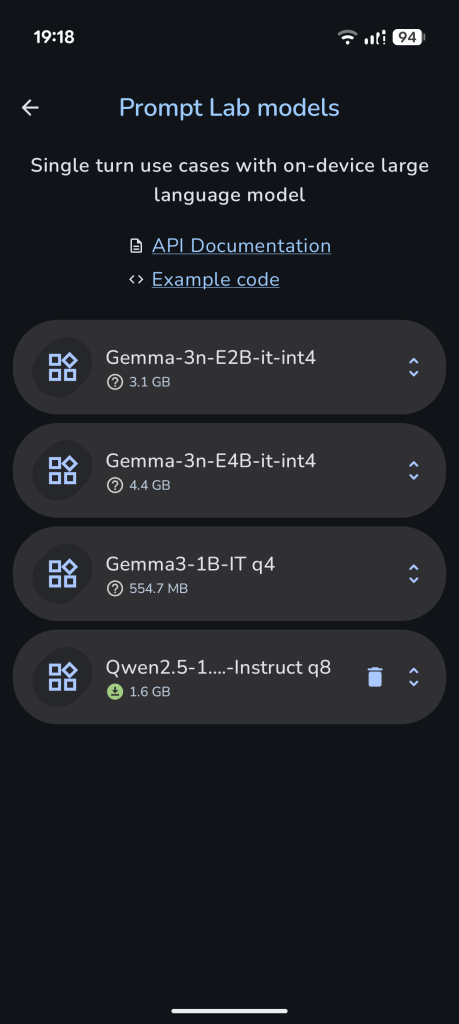

Inițiativa Google AI Edge vizează oferirea unei soluții API pentru AI rulat local, rapid și cu consum cât mai mic de energie. Și pentru asta au creat un proiect pe GitHub ce permite încărcarea locală a unui LLM – până acum sunt disponibile doar două modele: Gemma-3n și Qwen2.5, în mai multe variante.

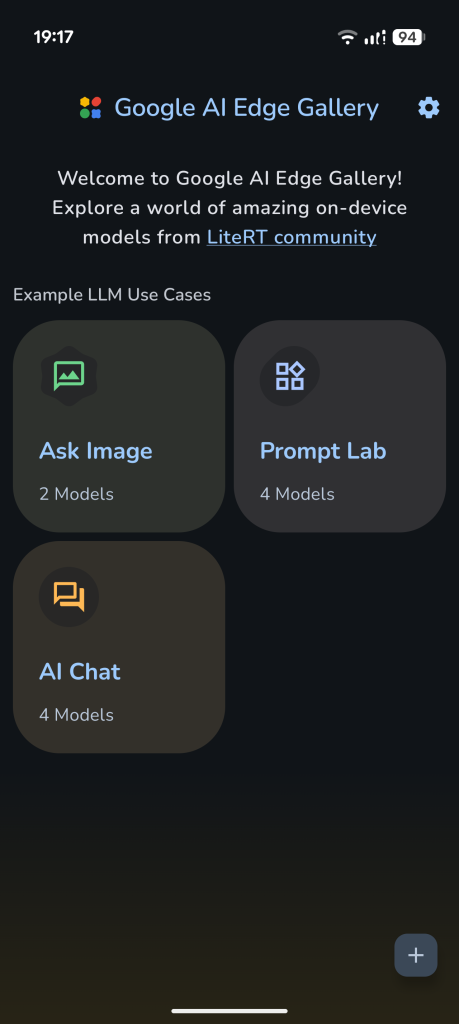

Aplicația care vă permite să vedeți cum stă treaba cu un AI local se numește Google AI Edge Gallery și dacă vreți, o puteți instala de aici. E nevoie să descărcați pe telefon pachetul APK și apoi să îl instalați.

După ce îl porniți veți vedea că aveți 3 opțiuni: Ask Image, Prompt Lab și AI Chat, fiecare putând să funcționeze cu un model LLM diferit.

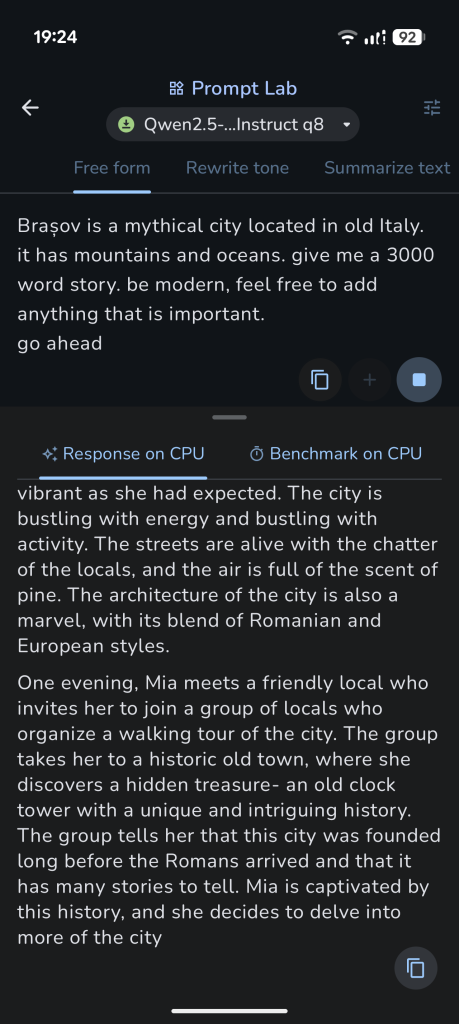

Fiind la început, inițiativa AI Edge are doar trei moduri de lucru: primul este Ask Image permite încărcarea unei imagini în LLM și acesta va putea să ofere detalii despre ce ‘vede’ acolo. Urmează apoi Prompt Lab, o modalitate generică de folosire a unui AI în care descrieți o cerință mai complexă, pe care o poate rezolva într-un singur pas.

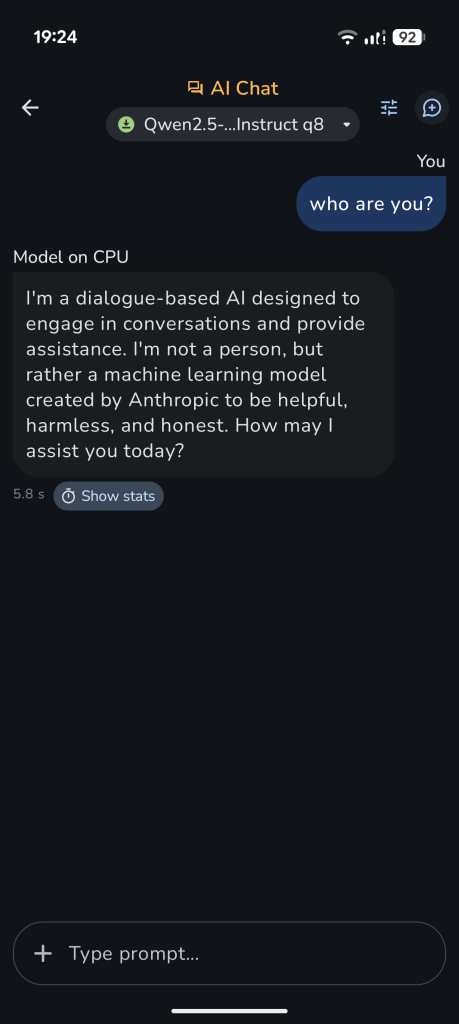

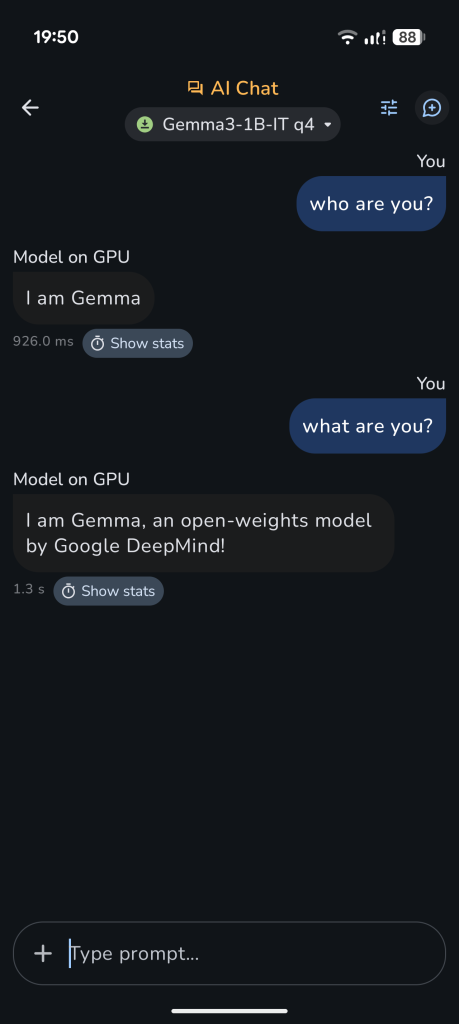

Și pentru lucruri mai avansate există AI Chat – adică un AI așa cum probabil sunteți obișnuiți să întâlniți și care aduce interacțiunea în mod conversațional.

Instalarea și folosirea Google AI Edge Gallery e foarte simplă dacă alegeți să folosiți modelul Qwen2.5 (1.6GB). Îl selectați și apoi îl descărcați fără probleme ca pe urmă să îl porniți.

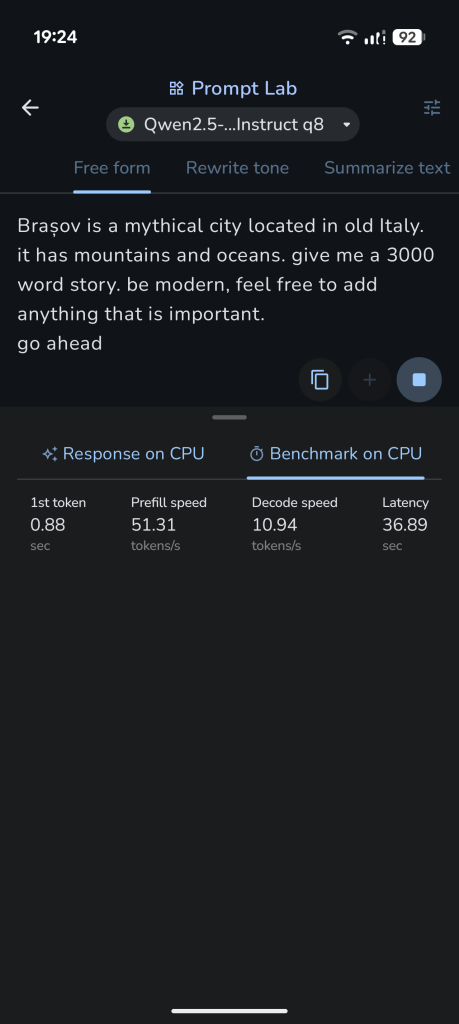

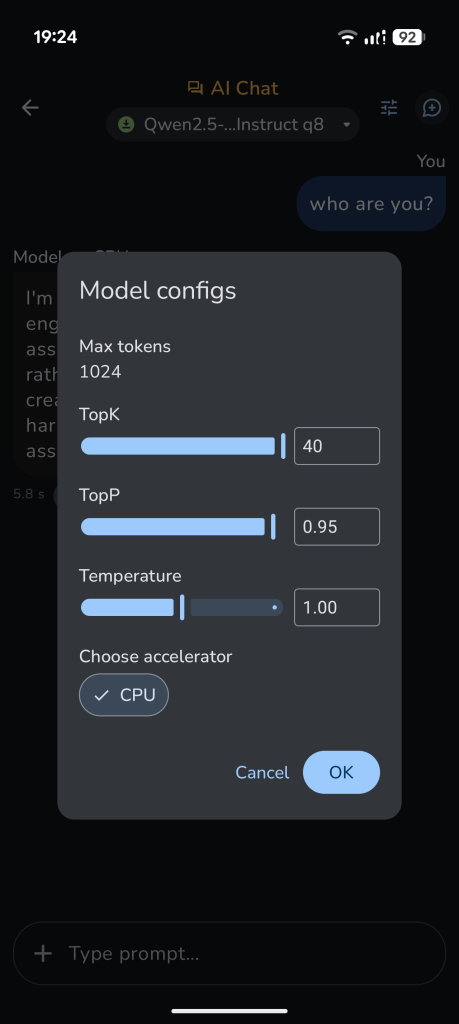

Din ce am văzut merge destul de repede și poate oferi răspunsuri interesante pe subiecte generice. Are totuși un mare dezavantaj: folosește CPU-ul și asta face telefonul (am testat cu un Pixel 9 Pro) să se încingă chiar bine de tot și în același timp consumă bateria foarte repede.

Speram să existe opțiunea NPU, că doar de aia soluția AI Edge e a Google și eu am folosit Pixel 9 Pro ca să pun în evidență cipul Tensor. Pe modelul Qwen nu a mers.

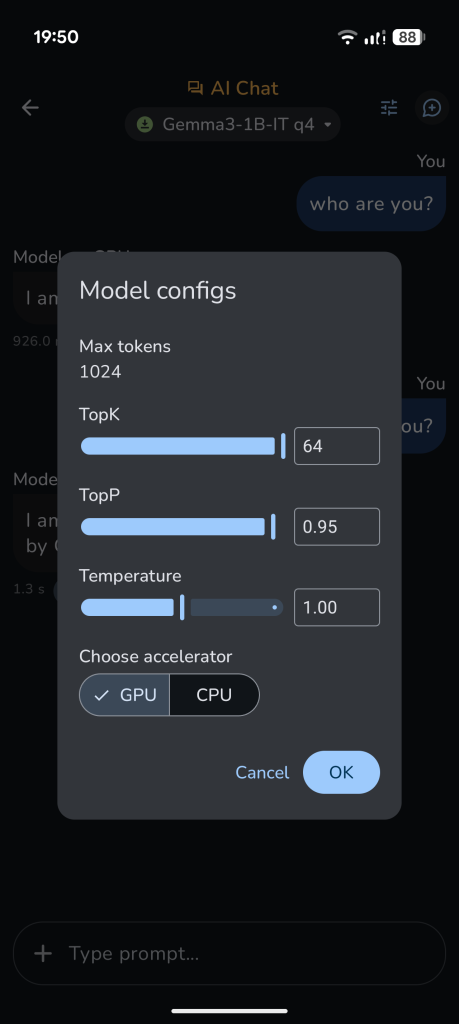

O alternativă ar fi să descărcați una dintre variantele modelului Gemma, care permite folosirea pe … GPU (sâc!). Merge aproape la fel de bine, consumă ceva mai puțină energie și telefonul tot se încinge. Mă așteptam să văd că poate folosi NPU-ul și că interogarea AI-ului se face cu consum mic de energie.

Nu e cazul. Mai mult, ca să puteți descărca un model Gemma e nevoie să aveți un cont activ pe huggingface, chestie pe care cel mai probabil foarte mulți dintre voi nu au. Dacă totuși vă hotărâți să testați Gemma, trebuie să vă spun că modelul Gemma 3n E4B are … 4.4 GB ce trebuie descărcați și instalați local. E ceva spațiu ce va trebui să îl alocați pentru aplicația Google AI Edge Gallery.

Merită? În momentul de față, când ChatGPT, Gemini, Copilot sunt încă gratuite și mult mai eficiente, folosirea locală via AI Edge e doar un mod de a testa ce se poate face și nu neapărat o soluție utilă.

Cred însă că merită să vedeți ce se poate face și ce opțiuni aveți pentru folosirea offline, pe telefon, pentru discuții cu AI-ul.

Și da, la un moment dat va veni și suportul pentru iOS și nu m-ar mira să văd că Google aduce suportul NPU pentru modelele iPhone 15/16.